想像してみてください:年末の賑わいの中、世界的な大手 EC 企業は、世界中の顧客からのオンライン注文の急増に直面しています。そうすると、同社のデータパイプラインは、相互接続されたシステムの迷宮をナビゲートするための、タイムリーな商品配送のためのシームレスな情報の流れの確保が最も重要になります。なのにデータパイプラインに潜む重大なエラーは検出されず野放しにされ、それが遅延や顧客の不満、多額の財務的損失を引き起こしています。この教訓的なケースは、データパイプラインのモニタリングが不可欠であることを強調しています。これは、このような災難から守り、データ統合の可能性を最大限に引き出すのに欠かせないプラクティスなのです。

データパイプラインのモニタリングにおける5つのポイント:

- ロギングフレームワークや観測可能システムなど、適切なモニタリングツールを活用することで、データパイプラインのバグを効率的に監視および特定する。

- データ可視化ツールにより、データパイプラインに関する貴重なインサイトを得ることができ、レイテンシ、エラー率、データスループット、その他の重要な側面を分析できる。

- データパイプラインを一貫して見直し、最適化することで、データ統合の目標が達成され、それによってシームレスなデータフローと高品質の成果が保証される。

- ETL / ELT 手法の力を活用し、データパイプラインのモニタリングを強化することで、変換段階でデータを観察でき、その正確性を確保することができる。

- 強固なモニタリングツール、データの可視化、継続的なレビュー、ETL / ELT 技術を組み合わせることで、効率性を最大化して組織のデータエクセレンスを推進する包括的なデータパイプラインのモニタリング戦略を確立できる。

包括的なデータパイプラインのモニタリング戦略を実施することで、組織はデータ統合の最適化や情報に基づいた意思決定をでき、今日のデータ主導の状況において優れたデータを推進することができるのです。

そこで本記事では、データパイプラインのモニタリングがデータ統合ソリューションの最適化にどのように役立つのか、またビジネスに適したモニタリングツールを選択するためのオプションについて見ていきます。

データパイプラインのモニタリングをすべき理由

データパイプラインのモニタリングは、包括的な分析のために[ソース]と[デスティネーション]間のデータの正常なフローを保証するのに欠かせないプラクティスです。データパイプラインを積極的に監視することで、組織はデータの品質維持、ユーザーエラーのリスク軽減、OCR(Optical Character Recognition/Reader:光学的文字認識)のデータの不正確さの排除、重要な分析プロセスに影響を与える可能性のあるその他のバグの防止ができます。

また、GDPR(EU一般データ保護規則)や CCPA(カリフォルニア州消費者プライバシー法)のようなデータガバナンスのフレームワークが厳格な遵守を要求する時代には、さまざまな場所を通過するデータの品質を監視することは、政府による多額の制裁金を回避するための戦略的な必須事項となります。さらに、パイプラインを積極的にモニタリングすることで、セキュリティ対策が強化され、それによって機密データへの不正アクセスを防ぎ、潜在的な侵害に対する組織の防御が強化されます。

データパイプラインのモニタリング法

データパイプラインのモニタリングには、効果的な戦略やツールが数多くありますが、最も一般的な方法には、パイプラインへの ETL / ELT の使用、モニタリングおよびデータ可視化ツールへの投資、パイプラインの継続的な見直しなどがあります。

データパイプラインのモニタリングの目的および KPI の決定

画像出典: http://ak.vbroek.org/project/data-pipeline-graphic/

データパイプラインのモニタリングに着手する前に、組織固有のニーズに沿った明確な目的を確定することが非常に重要です。例えば、GDPR や CCPA のようなデータガバナンスフレームワークへの準拠で、データ品質のモニタリングの必要性が上がるかもしれません。このような原則を守らなかった場合、政府から高額な罰金が科される可能性があるため、ある場所から別の場所へ移動する際にデータの品質を追跡することが重要になります。

また、組織はデータパイプラインのモニタリングの取り組みの有効性を測るために、それに関連する KPI(主要業績評価指標)も特定しないといけません。

その KPI は以下のようなものがあります:

- データレイテンシー:パイプラインをデータが移動するのにかかる時間をモニタリングする

- 可用性:パイプラインが正常に機能する時間をモニタリングする

- 利用状況:CPU やディスク容量など、パイプラインが使用するリソースの数をモニタリングする

選択する KPI は、データパイプラインのモニタリングの目的、使用するモニタリングツール、作成したパイプラインのタイプ(ETL/ELT パイプライン、イベント主導型パイプライン、ストリーミングパイプラインなど)など、さまざまな要因によって異なります。

目標を特定の KPI に合わせることで、組織はデータ統合ワークフローを効果的に追跡して改善することができるのです。

適切なモニタリングツールの選択

データパイプラインのモニタリングの目的と KPI を確定した後、適切なモニタリングツールを選択する必要があります。このソフトウェアツールは、組織内のデータパイプラインの機能性と全体的な健全性に関する情報を集め、それによって、バグは特定されて全てが円滑に稼動していることが保証されます。そして、モニタリングツールには以下のようなものがあります:

- ロギング・フレームワーク

- 観測可能性ツール

- データ可視化ツール

では、そのソフトの詳細について見ていきましょう:

ロギング・フレームワーク

ロギング・フレームワークは、データソースやターゲットシステムなど、データパイプラインに関わる様々なコンポーネントからログデータを集めます。このツールは、個々のデータパイプラインのジョブのログを生成し、ユーザーエラーなど、パイプラインに影響を与えるさまざまなイベントを記録します。ベストなロギング・フレームワークは、リアルタイムでログデータを集めてくれるので、それによってバグが発生したときやエラーの根本原因を特定できるようになります。

観測可能性ツール

観測可能性ツールもまた、さまざまなパイプラインのコンポーネントからデータを集めますが、パイプラインがデータを保存する場所やデータ処理がどのように行われるかを含め、パイプライン全体をより全体的かつ包括的に把握することができます。このツールはまた BI(ビジネスインテリジェンス)のワークロードを最適化するためのデータ活用方法に関するインサイトも提供します。ベストな観測可能性ツールは、AI(人工知能)、ML(機械学習)、予測分析、およびその他の方法を使って、パイプラインに関するインテリジェンスをチームに提供する正確なデータインサイトを生成します。

データ可視化ツール

データ可視化ツールは、ロギング・フレームワークや観測可能ツールからのさまざまなメトリクスや KPI を表示し、それによってデータパイプラインに関するインサイトが生み出されます。また、データ可視化ツールで、データセットがグラフ、チャート、レポート、ダッシュボードの形で表示されることがあり、それによってデータパイプラインのワークフローをよりよく理解することができるようになります。

上記のモニタリングツールのリストは網羅的なものではなく、他のテクノロジーと重複する機能があるソフトウェアもあるかもしれません。例えば、ベストな測可能ツールは、データ可視化機能も備えており、それによってパイプラインの観測や分析が実現します。ちなみに、オープンソースや商用のロギング・フレームワーク、データ観測可能性ツール、データ可視化ツールは市場に出回っています。

Integrate.io は、エラーのない正常なデータパイプラインの作成を支援するだけでなく、データの可観測性とモニタリングに関するインサイトを生成し、エラーなどの何かしらが発生した場合にアラートを送信します。例えば、パイプラインで何か問題が発生したときにカスタム通知を受け取り、データ品質を維持するためのアクションを取ることができます。

データパイプラインの継続的な見直し

効果的なデータパイプラインのモニタリングは、1回限りの作業ではなく、継続的なプロセスです。また、モニタリングが有益なのはパイプライン作成のときだけではありません。データがある場所から別の場所へ流れていくのを監視し続けることで、データガバナンスガイドラインの準拠、ボトルネックの回避、価値あるBI の生成、データ統合ワークフローの改善ができます。さらに、継続的なモニタリングには、ビジネスの規模に応じたパイプラインの追跡も含まれます。より多くのビッグデータが組織内を流れるようになると、そのデータを適切な場所にうまく移動させるパイプラインが必要になりますからね。

データパイプラインを見直す最善の方法の1つに、パイプラインが長期にわたってどのように機能するかを文書化して、その結果をデータエンジニアリングチームと共有するというのがあります。パイプラインがどのようにデータ統合を自動化し、データウェアハウスやデータレイクなどの[ソース]と[デスティネーション]の間でデータを移動させるかを学ぶことで、今後さらに成功するパイプラインを作成することができます。また、データパイプラインを定期的にテストすることも、データが問題なく正しい場所に移動することを確認するために重要です。

ETL / ELT を使ったデータパイプラインのモニタリング

データストリーミング、バッチ処理、イベント駆動型アーキテクチャなど、さまざまな方法でデータパイプラインを作成することができますが、ETL(抽出、変換、格納)や ELT(抽出、格納、変換)で、そのパイプラインのモニタリングができます。例えば ETL を挙げてみましょう:

- ETL が、CRM(顧客関係管理)システムやトランザクションデータベースなどのデータソースからデータを抽出し、ステージングエリアに配置する。

- 次に、変換のステージに移る。このプロセスでは、データのクレンジングと検証が行われ、データが正確で分析に適した形式であることが保証される。なお、パイプラインのこの時点で、データを監視し、パイプラインの実行方法に問題があれば発見することができる。

- 最後に、ETL がデータをウェアハウス や Amazon Redshift、Google BigQuery、Snowflake のような中央レポジトリに格納する。

ユースケースによっては、ELT を使って、分析用にデータを新しい場所に移動することもできます。このデータ統合方法は、ETLの「変換」と「格納」のステージが逆になり、「変換」は中央レポジトリ内で行われますが、変換のステージでもパイプラインを監視し、データの一貫性、クリーンさ、コンプライアンスを確保することができます。

Integrate.io がデータパイプラインのモニタリングとデバッグに役立つ方法

パイプラインのモニタリングは、データ品質を確保し、分析に影響を与えるおそれのあるエラーの可能性を減らすために非常に重要です。ただ、上記の通り、パイプラインを追跡するプロセスは大変であり、モニタリングの目的決定、適切なKPI の選択、適切なツールへの投資、パイプラインの定期的なモニタリングおよび文書化が必要です。

Integrate.io は、さまざまなソースやロケーション間でデータを同期する200以上のコード不要のデータコネクタによってデータパイプラインプロセスを自動化することから、データエンジニアリングは必要なくなります。必要なパイプラインを実行するために、SQL や Python のようなプログラミング言語の経験はもう必要ないのです。また、Integrate.io は、パイプラインを監視して問題を特定できるようになる、データ観測性のインサイトも提供します。データの問題が発生すると、即座にカスタム通知を受け取ることができることから、データセットの質が上がります。

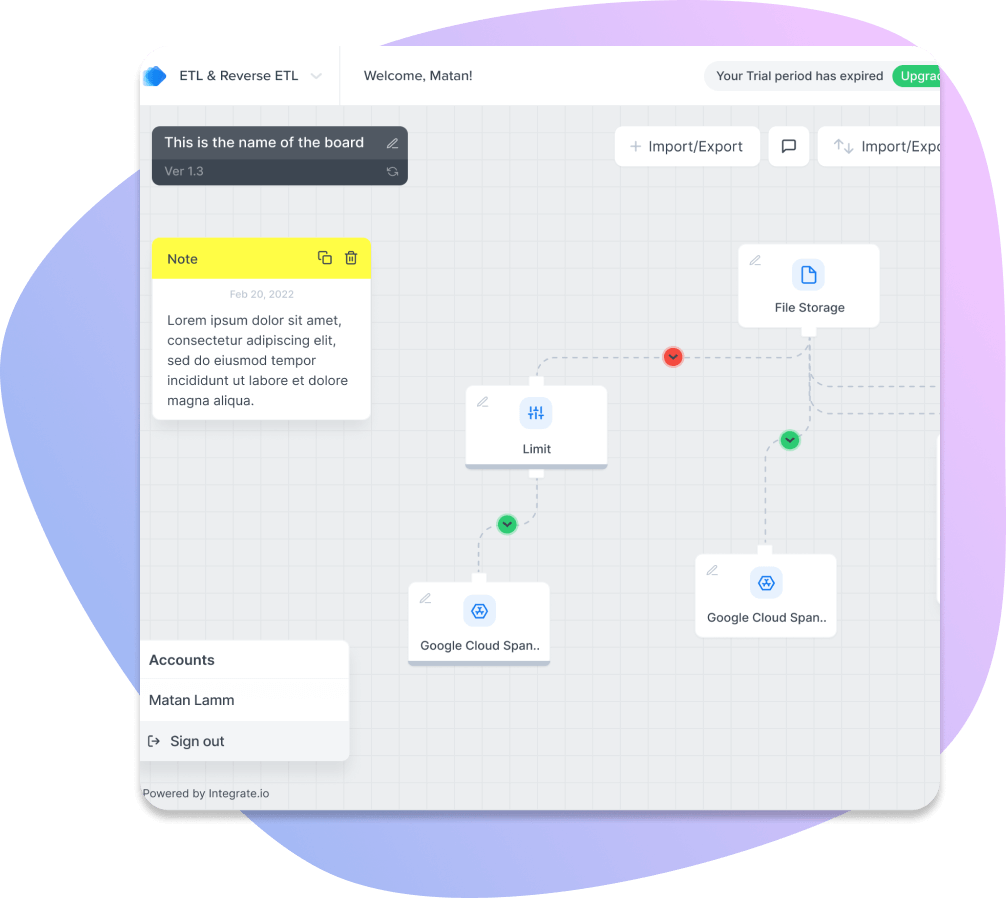

Integrate.io の使いやすい ドラッグ&ドロップのインターフェース

また、Integrate.io には、データ統合において以下のようなメリットもあります:

- Integrate.io の強力なドラッグ&ドロップのインターフェースを使って、コードを一切記述することなくETL、ELT、CDC、リバース ETL パイプラインを数分で作成できる。

- 業界最速の ELT のデータレプリケーションプラットフォームのメリットを享受し、毎分ごとにデータを統一して、レポートのための「信頼できる唯一の情報源(Single source of truth)」を作成する。

- Integrate の API 管理ソリューションにより、セルフホストで安全な REST API を設計できる。REST API を即座に読み書きし、データ製品からより多くの価値を得られる。

今なら14日間の無料トライアルでビッグデータのパワーを体感できます。また、皆さん独自のビジネスユースケースに対応するため、当社のエキスパートとのデモをぜひご予約ください。チームで皆さんの課題を特定し、1対1でしっかり向き合って解決策を検討致します。

まとめ

結論として、データパイプラインのモニタリングは、データ統合の効率性を最適化し、データ資産の可能性を最大限に活用しようとする組織にとって不可欠な手法です。強固なモニタリングのフレームワークの導入、明確な目的と KPI の確定、適切なツールの選択、パイプラインの継続的な見直し、ETL / ELT のような手法の活用によって、企業はシームレスなデータフローの確保、規制への準拠、貴重なビジネスインサイトの解放を実現できるのです。Integrate.io のような選択肢も含め、利用可能なモニタリングツールを色々と検討し、効率的でエラーのないデータパイプラインで組織を強化して、今日のデータ主導の状況で卓越したデータを実現しましょう。

そして、データパイプラインのモニタリングは継続的なプロセスであり、主体的であり続けることが成功の鍵であることを忘れないでください。データ パイプラインの監視、デバッグ、最適化の力を活用して、組織のデータ主導の可能性を最大限に引き出しましょう。